Tệp robots.txt được tạo ra nhằm thêm nội dung các quy tắc chặn các công cụ tìm kiếm thu thập và lập chỉ mục các liên kết URLs của trang web, nếu bạn không thêm tệp robots.txt mặc định sẽ cho phép các công cụ tìm kiếm thu thập.

Các công cụ tìm kiếm như: Google, Bing, Yahoo, Twitter, Facebook...., sử dụng các thuật toán gọi là bot thu thập truy cập liên kết chính của mỗi trang phân tích thu thập tất cả các liên kết URLs đang có trong trang đó sau đó tìm kiếm tệp robots.txt, thẻ meta, thuộc tính rel trong liên kết để xem liên kết nào bị chặn, liên kết nào được phép truy cập.

Tệp robots.txt vẫn được các công cụ tìm kiếm ưu tiên khi phân tích, khi đọc nội dung trong tệp các bot thu thập biết được các liên kết nào được phép thu thập và lập chỉ mục và các liên kết nào đang bị chặn.

Mỗi trình thu thập đều có một tên riêng được chỉ định rõ ràng trong nội dung tệp robots.txt như ví dụ sau: Google - Googlebot, Bing - Bingbot, Yahoo - Yahoobot, Twitter - Twitterbot, Facebook - Facebot..., ngoài ra bạn có thể chỉ định không rõ ràng bằng thuộc tính (*)

Sau mỗi loại bot được thêm bằng 2 quy tắc: Allow (cho phép) và Disallow (chặn)

Cách tạo tệp robots.txt

Cấu trúc của tệp robots.txt có nội dung như sau:

User-agent: Tên bot của công cụ tìm kiếm

Disallow: Liên kết bị chặn

Allow: Liên kết cho phép

Sitemap: <domain>/sitemap.xml Sơ đồ trang web

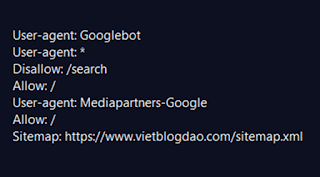

Ví dụ minh họa:

Giả sử mình sẽ cho phép các bot của Google, Twitter, Facebook, đối tác Google (Adsense) thu thập dữ liệu như sau:

User-agent: Googlebot

User-agent: Twitterbot

User-agent: Facebot

Disallow: /p

Disallow: /search

Allow: /

User-agent: Mediapartners-Google

Allow: /

Sitemap: https://www.vietblogdao.com/sitemap.xml

Khi đọc nội dung trong tệp hiểu được với các bot của Google, Twitter, Facebook chặn tất cả các liên kết trang tĩnh (/p) và các trang tìm kiếm (/search) và cho phép đối tác Google Mediapartners-Google thu thập tất cà liên kết.

Thêm quy tắc lọc từ những liên kết đã chặn hoặc chặn một liên kết từ các liên kết cho phép

Giả sử trong 2 quy tắc: Disallow: /p và Disallow: /search thêm quy tắc Allow lọc lấy các liên kết có trong các liên kết bị chặn này và chặn một liên kết từ các liên kết Allow: /, ví dụ:

User-agent: Googlebot

User-agent: Twitterbot

User-agent: Facebot

Disallow: /p

Disallow: /search

Disallow: /2018/11/cach-chia-se-bai-viet-len-facebook-an-toan-va-tuong-tac-cao.html

Allow: /

Allow: /p/about-us.html

Allow: /search/label/blogspot-seo

User-agent: Mediapartners-Google

Allow: /

Sitemap: https://www.vietblogdao.com/sitemap.xml

Thêm quy tắc (*) lọc nâng cao

Disallow: *?showComment=*

Disallow: *?spref=fb

Disallow: *?spref=tw

Disallow: *?spref=gp

Disallow: *?spref=pi

Disallow: *?utm_source=*

Với quy tắc thêm (*) này, không cần biết liên kết nào cứ liên kết có các giá trị đằng sau dấu (*) đều sẽ bị chặn.

Nguồn: VietBlogDao.Com

Các công cụ tìm kiếm như: Google, Bing, Yahoo, Twitter, Facebook...., sử dụng các thuật toán gọi là bot thu thập truy cập liên kết chính của mỗi trang phân tích thu thập tất cả các liên kết URLs đang có trong trang đó sau đó tìm kiếm tệp robots.txt, thẻ meta, thuộc tính rel trong liên kết để xem liên kết nào bị chặn, liên kết nào được phép truy cập.

Tệp robots.txt vẫn được các công cụ tìm kiếm ưu tiên khi phân tích, khi đọc nội dung trong tệp các bot thu thập biết được các liên kết nào được phép thu thập và lập chỉ mục và các liên kết nào đang bị chặn.

Mỗi trình thu thập đều có một tên riêng được chỉ định rõ ràng trong nội dung tệp robots.txt như ví dụ sau: Google - Googlebot, Bing - Bingbot, Yahoo - Yahoobot, Twitter - Twitterbot, Facebook - Facebot..., ngoài ra bạn có thể chỉ định không rõ ràng bằng thuộc tính (*)

Sau mỗi loại bot được thêm bằng 2 quy tắc: Allow (cho phép) và Disallow (chặn)

Cách tạo tệp robots.txt

Cấu trúc của tệp robots.txt có nội dung như sau:

User-agent: Tên bot của công cụ tìm kiếm

Disallow: Liên kết bị chặn

Allow: Liên kết cho phép

Sitemap: <domain>/sitemap.xml Sơ đồ trang web

Ví dụ minh họa:

Giả sử mình sẽ cho phép các bot của Google, Twitter, Facebook, đối tác Google (Adsense) thu thập dữ liệu như sau:

User-agent: Googlebot

User-agent: Twitterbot

User-agent: Facebot

Disallow: /p

Disallow: /search

Allow: /

User-agent: Mediapartners-Google

Allow: /

Sitemap: https://www.vietblogdao.com/sitemap.xml

Khi đọc nội dung trong tệp hiểu được với các bot của Google, Twitter, Facebook chặn tất cả các liên kết trang tĩnh (/p) và các trang tìm kiếm (/search) và cho phép đối tác Google Mediapartners-Google thu thập tất cà liên kết.

Thêm quy tắc lọc từ những liên kết đã chặn hoặc chặn một liên kết từ các liên kết cho phép

Giả sử trong 2 quy tắc: Disallow: /p và Disallow: /search thêm quy tắc Allow lọc lấy các liên kết có trong các liên kết bị chặn này và chặn một liên kết từ các liên kết Allow: /, ví dụ:

User-agent: Googlebot

User-agent: Twitterbot

User-agent: Facebot

Disallow: /p

Disallow: /search

Disallow: /2018/11/cach-chia-se-bai-viet-len-facebook-an-toan-va-tuong-tac-cao.html

Allow: /

Allow: /p/about-us.html

Allow: /search/label/blogspot-seo

User-agent: Mediapartners-Google

Allow: /

Sitemap: https://www.vietblogdao.com/sitemap.xml

Thêm quy tắc (*) lọc nâng cao

Disallow: *?showComment=*

Disallow: *?spref=fb

Disallow: *?spref=tw

Disallow: *?spref=gp

Disallow: *?spref=pi

Disallow: *?utm_source=*

Với quy tắc thêm (*) này, không cần biết liên kết nào cứ liên kết có các giá trị đằng sau dấu (*) đều sẽ bị chặn.

Nguồn: VietBlogDao.Com